网站换了服务器后出大问题了,大佬帮忙诊断分析一下 推荐热议 悬赏8元 已结束

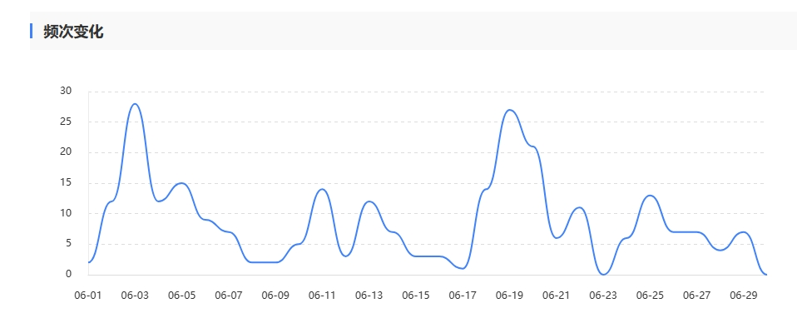

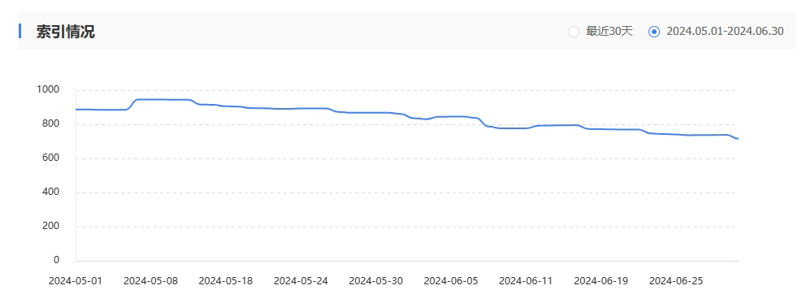

fst-tech。COM.。三月份换了服务器,数据和文件没有备份过来,相当于用老域名重新搭建一个网站。然后索引量一直掉,抓取频次从几百次降到个位数了,现在每天都更新原创高质量的内容,最近两个月也没有收录了。是被百度惩罚了吗?该怎么做才会恢复正常的抓取和收录呢?

原来的数据也不在了啊 ?

可以分析下日志,看看是否还一直抓取之前的链接

可以分析下日志,看看是否还一直抓取之前的链接

当网站更换服务器后出现索引量下降和抓取频次骤减的问题,这通常是由于搜索引擎爬虫在适应新环境时遇到了一些困难。为了尽快恢复正常的抓取和收录,以下是一些建议的步骤:

确保服务器稳定且响应迅速:

首先,检查新服务器的稳定性和性能。确保服务器能够快速响应请求,避免因为加载速度慢或宕机导致爬虫抓取失败。

如果可能的话,使用CDN加速服务,提升网站在全球范围内的访问速度。

检查URL和重定向:

确保所有旧的URL都已经正确重定向到新的服务器上对应的页面。错误的重定向或死链接可能会导致爬虫无法找到内容,从而降低抓取频次。

使用工具(如Google Search Console)检查网站上的重定向和404错误,并及时修复。

更新Sitemap并提交给搜索引擎:

创建一个新的Sitemap,列出网站上的所有重要页面。

将新的sitemap提交给搜索引擎(如Google Search Console、Bing Webmaster Tools等),帮助爬虫更快地找到并抓取新的内容。

检查Robots.txt文件:

确保robots.txt文件没有错误地阻止搜索引擎爬虫访问网站的某些部分。

如果需要,更新robots.txt文件以允许爬虫访问所有应该被抓取的页面。

增加外链和内链:

尝试从其他高质量网站获取一些外链,指向你的网站。这不仅可以提高网站的权威性,还可以帮助爬虫更快地找到你的网站。

在网站内部增加适当的内链,确保爬虫能够顺畅地在网站内部进行抓取。

创建和发布高质量内容:

定期发布高质量、有价值的内容,吸引用户访问和分享。这不仅可以提高网站的活跃度,还可以让搜索引擎爬虫更加频繁地访问你的网站。

确保内容具有原创性和独特性,避免与其他网站的内容重复。

使用搜索引擎优化(SEO)策略:

对网站进行关键词优化,确保网站内容符合搜索引擎的排名算法。

使用适当的标题标签、描述标签和关键词标签,帮助搜索引擎更好地理解你的网站内容。

监控和分析数据:

使用网站分析工具(如Google Analytics)监控网站的流量、访问来源和用户行为等数据。

定期检查搜索引擎的抓取日志和索引状态报告,了解爬虫对网站的抓取情况和问题所在。

与搜索引擎联系:

如果以上步骤都没有解决问题,你可以尝试联系搜索引擎的客服或技术支持团队,寻求帮助和建议。

最后,请记住,恢复网站的抓取和收录需要时间和耐心。遵循以上建议并持续努力,你的网站应该能够逐渐恢复到正常的抓取和收录状态。

我的网站更加

更换服务器有几个月的波动期属于正常现象,不用太担心,慢慢优化吧

我的网站更加